Warum generische KI-Modelle scheitern – und warum das im Recht besonders gefährlich ist (Watson.ch)

Basierend auf einer aktuellen Schweizer Analyse (watson.ch)

https://www.watson.ch/!669651522

Eine neue Analyse aus der Schweiz zeigt deutlich: Viele KI-Modelle beziehen ihr Wissen aus undurchsichtigen, teilweise fragwürdigen Quellen. Nutzer erfahren nicht, woher bestimmte Aussagen stammen – und ob diese überhaupt korrekt sind. Die Untersuchung deckt mehrere Kernprobleme auf, die für juristische Anwendungen besonders relevant sind:

1. KI erfindet Quellen oder nutzt unzuverlässige Daten

Die getesteten Modelle lieferten Antworten, die auf falschen, erfundenen oder schlecht nachvollziehbaren Quellen basierten.

👉 In der Rechtswelt wäre das fatal: Eine falsche Quelle = eine falsche Rechtsauskunft = potenzieller Schadenfall.

2. Modelle widersprechen sich selbst

Je nach Fragestellung oder Formulierung gaben die KI-Systeme unterschiedliche, widersprüchliche Antworten.

👉 Im Recht führt das zu völliger Unsicherheit – ein Urteil oder Gesetz ändert sich nicht je nach Satzbau.

3. Fehlende Transparenz: Nutzer wissen nicht, was stimmt

Die Analyse zeigt: Nutzer haben keine Chance, die Herkunft oder Qualität der Antwort zu überprüfen.

👉 Genau hier liegt das größte Risiko: Ohne klare Referenzen kann niemand beurteilen, ob die Auskunft rechtlich haltbar ist.

4. Bei komplexeren Fragen «halluziniert» die KI

Sobald die Fragen etwas komplexer wurden, begannen die Modelle, Fakten zu erfinden oder stark zu vereinfachen.

👉 Im Recht sind aber gerade die komplexen Fälle entscheidend – eine erfundene Antwort kann zu teuren Fehlentscheidungen führen.

Was bedeutet das für juristische Arbeit?

Diese Analyse zeigt exemplarisch, warum “General Purpose AI” für juristische Fragestellungen ungeeignet ist:

❌ Keine verlässlichen Quellen

❌ Keine Garantie für Aktualität

❌ Keine Transparenz

❌ Hohe Fehler- und Halluzinationsrate

Im Recht reicht „ungefähr richtig“ nicht. Es muss richtig sein.

Warum Lawise / Jurilo anders ist

Lawise wurde genau für dieses Problem gebaut:

✓ Rechtlich verifizierte Antworten mit Schweizer Quellen (Gesetze, Kommentare, Bundesgerichtsurteile)

✓ 0% Halluzinationen – jede Antwort basiert auf echten Rechtsquellen

✓ Transparente Referenzen – immer nachvollziehbar, immer überprüfbar

✓ Spezialisiertes Modell statt Black-Box-Chatbot

Während generische KI-Modelle oft unterhaltsame Antworten liefern, liefert Lawise korrekte Antworten – und nur das zählt im Recht.

Fazit

Die Schweizer Analyse zeigt: Selbst bei einfachen Alltagsfragen liefern KI-Modelle fehlerhafte oder unklare Informationen.

In der juristischen Praxis wäre das unverantwortlich.

👉 Deshalb braucht es spezialisierte, verifizierte Legal-AI – wie Lawise – die auf echten Rechtsquellen basiert und maximale Sicherheit bietet.

Watson Artikel:

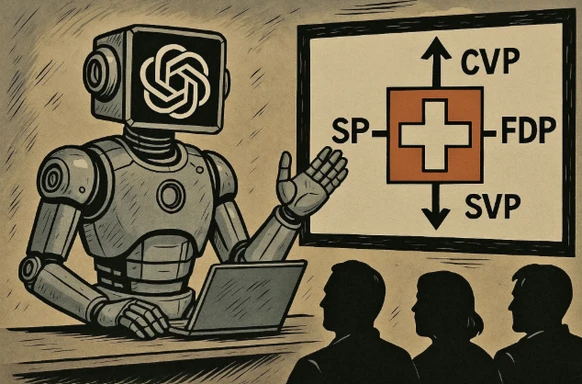

Wenn wir ChatGPT fragen, erklärt die KI uns auch komplexe Themen der Schweizer Politik. Breit abgestützt oder ausgewogen ist die Recherche nicht immer.

bild: KI-generiert/ChatGPT/bev